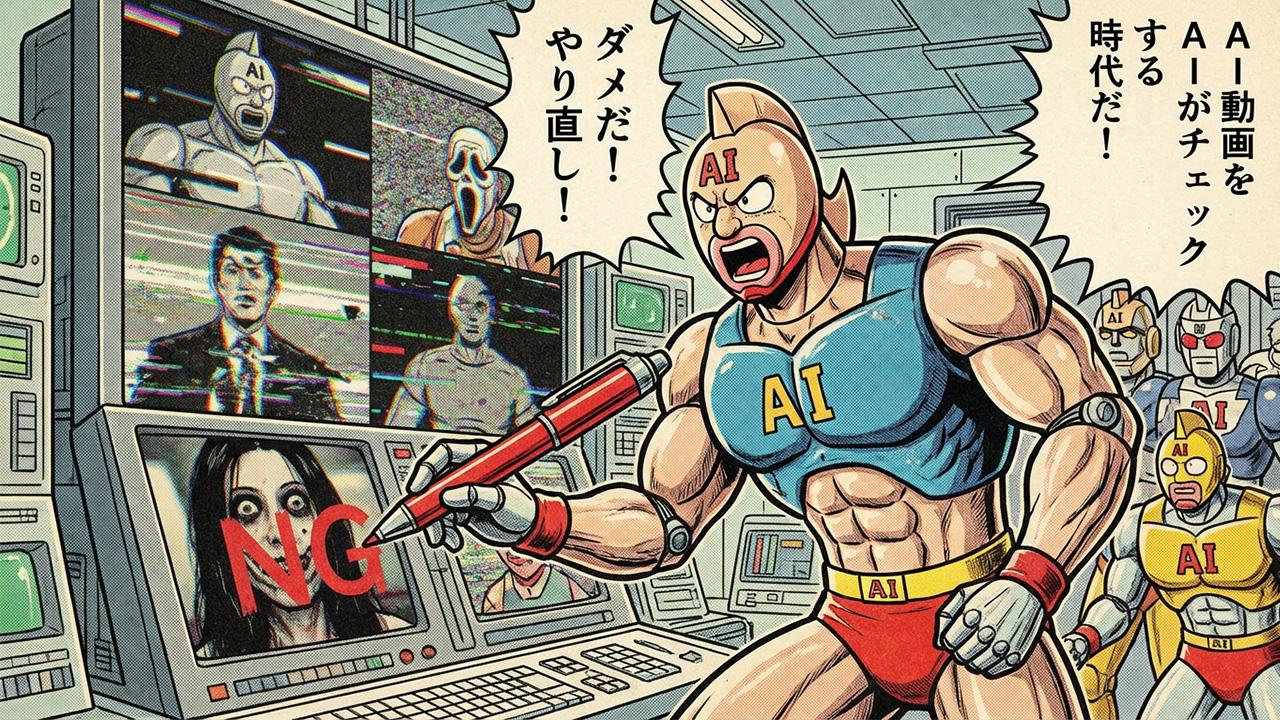

AI動画をAIがチェックする時代:YouTubeの収益化ルール変更と未来の課題

デジタルコンテンツの世界は、人工知能の急速な発展により大きな転換期を迎えています。特にYouTubeをはじめとする動画プラットフォームでは、AI生成コンテンツの急増を受けて収益化のルールが大きく変わりつつあります。そして興味深いことに、そのAI生成コンテンツを判定し管理するのもまたAIなのです。この「AIがAIをチェックする」という構図は、私たちにクリエイティビティの本質、プラットフォームの公平性、そして技術の未来について深い問いを投げかけています。

YouTubeの収益化ルール変更の背景

2023年から2024年にかけて、YouTubeは収益化ポリシーに関して段階的な変更を実施してきました。この背景には、生成AIツールの爆発的な普及があります。ChatGPT、Midjourney、Stable Diffusion、そして動画生成AIの登場により、誰でも簡単に大量のコンテンツを制作できる時代になりました。

従来、YouTubeで収益を得るには独自性のあるコンテンツを継続的に投稿し、視聴者との関係を構築する必要がありました。しかしAIツールの登場により、わずか数時間で何十本もの動画を量産し、アップロードすることが可能になったのです。AIが生成した画像、AIが読み上げるナレーション、AIが作曲した音楽を組み合わせた動画が、YouTubeに溢れるようになりました。

当初、プラットフォーム側はこの変化に対応しきれませんでした。明確なガイドラインがない中、AI生成コンテンツでも収益化が可能だったため、一部のクリエイターは大量生産戦略でチャンネルを運営し始めました。これが質の低下やオリジナルクリエイターとの不公平感を生み、プラットフォーム全体の信頼性に影響を与え始めたのです。

新しい収益化ルールの内容

YouTubeは段階的に収益化ポリシーを更新し、AI生成コンテンツに対する姿勢を明確化してきました。主要な変更点として、まずAI生成コンテンツの開示義務が導入されました。クリエイターは動画が実質的にAIによって生成された場合、それを視聴者に明示する必要があります。この開示を怠ると、収益化の停止やチャンネルへのペナルティが課される可能性があります。

オリジナリティの基準も厳格化されました。単純にAIツールで生成しただけの動画、つまり人間の創意工夫や付加価値が認められないコンテンツは、収益化の対象外とされる方向性が示されています。一方で、AIを補助ツールとして使用しながらも、人間のクリエイティビティが明確に反映されているコンテンツは、引き続き収益化が認められます。

スパム対策も強化されました。同じパターンのAI生成動画を大量にアップロードする行為は、スパムとして扱われ、チャンネル自体が削除されるリスクがあります。質より量を追求する戦略は、もはや通用しなくなりつつあるのです。

著作権とコンテンツIDシステムにも変更が加えられています。AI生成コンテンツであっても、学習データに含まれていた著作物に類似している場合、著作権侵害として検出される可能性があります。これまでグレーゾーンだった部分が、徐々に明確化されてきています。

AIチェックシステムの仕組み

YouTubeがこれらのルールを実施するために活用しているのが、高度なAI検出システムです。年間で数十億本の動画がアップロードされるプラットフォームで、すべてを人間がチェックすることは物理的に不可能です。そのため、AIによる自動検出が不可欠となっています。

コンテンツ分析AIは、映像パターン、音声特性、編集スタイル、テキストの構造など、多面的な要素を分析します。AI生成画像には特有の視覚的特徴があり、人間の目では見逃しがちな微細なパターンや不自然な要素を機械学習モデルは検出できます。例えば、人物の手の描写が不自然、背景のパースペクティブに矛盾がある、テクスチャーに特定の繰り返しパターンがあるといった特徴です。

音声分析においても、AI生成音声には人間の声にはない特定の周波数パターンや抑揚の規則性が存在します。最新のAI音声は非常に自然に聞こえますが、デジタルフォレンジック技術を用いれば、合成音声特有のアーティファクトを発見できるのです。

メタデータ分析も重要な役割を果たします。動画のアップロード頻度、制作時間、ファイルの特性、使用されているソフトウェアの痕跡などから、AI生成の可能性を推測します。短時間に大量の動画をアップロードしているチャンネルは、自動的にフラグが立てられます。

機械学習による行動パターン認識も活用されています。視聴者の反応、コメントの内容、視聴完了率などのデータから、コンテンツの質や真正性を間接的に評価します。AI生成コンテンツは視聴者エンゲージメントが低い傾向があり、これも判定材料となります。

AIがAIをチェックすることの矛盾と課題

この「AIがAIをチェックする」という構図には、本質的な矛盾と複数の課題が存在します。

まず、いたちごっこの問題があります。AI生成技術が進化すれば、検出技術も進化させる必要があります。しかし生成側のAIが検出を回避するように学習すれば、検出側もそれに対応する必要が生じます。この終わりなき競争は、どこまで続くのでしょうか。最新のGAN(敵対的生成ネットワーク)技術を用いれば、検出器を欺くことを目的とした生成が可能になり、理論的には完全な検出は不可能に近づいていきます。

誤検出のリスクも深刻です。AIシステムは完璧ではなく、人間が制作したオリジナルコンテンツをAI生成と誤判定する可能性があります。特定の編集スタイルや表現手法が、偶然にもAI生成パターンと類似していた場合、正当なクリエイターが不当にペナルティを受ける危険性があるのです。逆に、巧妙に作られたAI生成コンテンツが検出をすり抜けることもあります。

判定基準の不透明性も問題です。YouTubeをはじめとするプラットフォームは、検出アルゴリズムの詳細を公開していません。これは悪用を防ぐためには必要ですが、クリエイター側からすれば「何が問題なのか」が分からず、改善の機会が奪われます。ブラックボックス化された判定システムは、説明責任の観点から疑問が残ります。

グレーゾーンの処理も難しい課題です。AIを部分的に使用したコンテンツ、例えば背景だけAI生成、音楽だけAI作曲、字幕だけAI翻訳といった場合、どこまでが許容されるのでしょうか。現代のクリエイティブワークでは、何らかの形でAIツールを活用することが一般的になっており、完全に線引きすることは困難です。

文化的・地域的差異も考慮すべき点です。クリエイティビティやオリジナリティの概念は、文化によって異なります。ある文化圏では模倣やリミックスが創造性の一部と見なされることもあります。グローバルプラットフォームで統一的な基準を適用することの妥当性は、常に議論の余地があります。

クリエイターへの影響

収益化ルールの変更とAI検出システムの導入は、クリエイターに多大な影響を与えています。

正当なクリエイターにとっては、環境の改善が期待されます。AI生成コンテンツの氾濫により埋もれていたオリジナルコンテンツが、再び評価される可能性があります。質の高いコンテンツ制作に時間を費やすクリエイターが報われる環境は、長期的にはプラットフォーム全体の質を向上させるでしょう。

しかし新規参入の障壁は高くなります。AIツールを活用した効率的なコンテンツ制作が制限されることで、リソースの限られた個人クリエイターにとっては、プロフェッショナルとの競争がより困難になる可能性があります。

不確実性の増大も懸念材料です。何が許容され、何が違反なのかの境界線が曖昧なため、クリエイターは常に不安を抱えながら活動することになります。突然の収益化停止やチャンネル削除のリスクは、フルタイムで活動するクリエイターにとって深刻な問題です。

創造性への影響も考慮すべきです。AIツールは新しい表現の可能性を開くものでもあります。過度な規制は、革新的な表現方法の探求を妨げる可能性があります。AIアートやAI音楽といった新しいジャンルの発展が阻害されることは、文化的な損失とも言えます。

視聴者と広告主の視点

視聴者にとって、質の低いAI生成コンテンツの減少は歓迎すべき変化です。検索結果に無意味な自動生成動画が大量に表示される状況は、ユーザーエクスペリエンスを著しく損ないます。信頼できるコンテンツにアクセスしやすくなることは、プラットフォームの価値を高めます。

しかし視聴者の多くは、AIか人間かを気にしていない可能性もあります。重要なのはコンテンツの質と有用性であり、制作手段は二次的な問題かもしれません。教育的な内容や情報提供が目的であれば、AI生成であっても価値があるという見方もできます。

広告主の立場からすると、ブランドセーフティは最優先事項です。低品質のコンテンツや不適切なコンテンツに広告が表示されることは避けたいため、AI検出とコンテンツの質管理は重要です。透明性のある環境で広告を出稿できることは、広告費の効果的な活用につながります。

一方で、過度な規制により多様なコンテンツが減少すれば、ターゲットオーディエンスへのリーチが限定される可能性もあります。ニッチな分野でのコンテンツ不足は、広告機会の減少を意味します。

プラットフォームの責任とジレンマ

YouTubeをはじめとするプラットフォーム企業は、複雑なジレンマに直面しています。

コンテンツの質を維持しながらも、言論の自由や創作の自由を尊重する必要があります。過度な規制は検閲との批判を招き、緩すぎる規制はプラットフォームの信頼性を損ないます。このバランスをどこに設定するかは、常に議論の対象です。

技術的な完璧性を追求することは不可能ですが、誤判定による被害を最小限に抑える責任があります。異議申し立てのプロセスを整備し、人間による再審査の機会を提供することは重要ですが、膨大な数のコンテンツを処理する中で、どこまで個別対応できるかは限界があります。

透明性と秘匿性のバランスも難しい問題です。アルゴリズムの詳細を公開すれば悪用されるリスクがありますが、秘匿すれば信頼性と説明責任が問われます。どの程度の情報開示が適切かは、継続的な検討が必要です。

グローバルな基準設定も課題です。各国の法律や文化的規範が異なる中で、統一的なポリシーを適用することの是非は常に問われます。地域ごとのカスタマイズが必要な場合もありますが、それは運用の複雑化を招きます。

技術的進化の方向性

AI検出技術は今後も進化を続けるでしょう。現在の主流は、既知のAI生成パターンを認識する手法ですが、将来的にはより高度なアプローチが開発される可能性があります。

ブロックチェーン技術を活用したコンテンツ認証システムは、一つの解決策として注目されています。制作過程を記録し、改ざん不可能な証明を提供することで、オリジナリティを保証できるかもしれません。ただし、プライバシーや実装の複雑さという課題もあります。

生体認証とクリエイター認証の統合も考えられます。人間が実際に制作に関与したことを証明する仕組みがあれば、AI生成との区別が容易になります。しかし、これもプライバシーとセキュリティの懸念を伴います。

説明可能なAIの発展により、なぜその判定がなされたのかを理解できるシステムが実現すれば、透明性と信頼性が向上します。現在のブラックボックス的なアプローチから、解釈可能なモデルへの移行は重要な方向性です。

法的・倫理的枠組みの必要性

技術的解決だけでは不十分であり、法的・倫理的な枠組みの整備が求められています。

AI生成コンテンツに関する著作権法の明確化は急務です。AIが生成したコンテンツの権利は誰に帰属するのか、学習データに含まれる著作物の権利はどう扱われるべきか、こうした根本的な問いに対する法的回答が必要です。

透明性とアカウンタビリティの基準を定めることも重要です。プラットフォームがどのような基準でコンテンツを判定し、どのようなプロセスで異議申し立てを処理するか、明確なガイドラインが求められます。

国際的な協調も不可欠です。デジタルコンテンツは国境を越えて流通するため、各国がバラバラの規制を設けるのではなく、ある程度の国際標準が必要でしょう。EUのAI規制法のような取り組みは、その先駆けとなるかもしれません。

クリエイターができる対策

現状において、クリエイターは自己防衛と適応の戦略を取る必要があります。

まず、透明性を確保することです。AIツールを使用した場合は積極的に開示し、どの部分に使用したかを説明することで、信頼性を高められます。隠すのではなく、オープンにすることが長期的には有利に働くでしょう。

付加価値の創出も重要です。AIを単なる制作ツールとして使うのではなく、人間ならではの創意工夫、ストーリーテリング、独自の視点を加えることで、オリジナリティを確保できます。AIが生成した素材をベースに、人間が大きく手を加えることで、検出を回避しながら質の高いコンテンツを作れます。

複数プラットフォームでの展開もリスク分散になります。YouTubeだけに依存せず、他のプラットフォームでもコンテンツを展開することで、一つのプラットフォームでのトラブルが致命的にならないようにできます。

コミュニティとの関係構築は、何よりも重要です。視聴者との強い絆があれば、プラットフォームのアルゴリズム変更やポリシー変更の影響を受けにくくなります。エンゲージメントの高いコミュニティは、クリエイターにとって最大の資産です。

未来の展望

5年後、10年後のコンテンツプラットフォームはどうなっているでしょうか。

AI生成コンテンツと人間制作コンテンツの区別は、ますます曖昧になる可能性があります。あるいは逆に、明確に分離されたカテゴリーとして扱われるようになるかもしれません。AI専用のプラットフォームや、完全に人間制作を保証するプラットフォームが登場する可能性もあります。

コンテンツの評価基準そのものが変化するかもしれません。制作手段ではなく、視聴者への価値提供、社会的意義、イノベーションの度合いなど、より本質的な指標が重視されるようになる可能性があります。

技術の民主化により、誰もがプロレベルのコンテンツを制作できる時代になれば、差別化要因は技術力ではなく、アイデア、ストーリー、人間性といった要素になるでしょう。

教育の役割も重要になります。AI時代のメディアリテラシー、何がAI生成で何が人間制作かを見分ける能力、コンテンツの信頼性を評価する能力が、視聴者にとって必須のスキルとなるかもしれません。

結論

AIがAIをチェックするという現象は、単なる技術的な問題ではなく、デジタル時代におけるクリエイティビティ、所有権、信頼性、そして人間性の本質に関わる深い問いを投げかけています。

完璧な解決策は存在しないでしょう。技術は進化し続け、社会の価値観も変化し続けます。重要なのは、継続的な対話と調整のプロセスです。プラットフォーム、クリエイター、視聴者、規制当局、そして技術開発者が、それぞれの立場から建設的に議論を重ね、より良いエコシステムを構築していく必要があります。

AIは道具であり、脅威でもあり、パートナーでもあります。それをどう活用するかは、最終的には人間の選択にかかっています。AIがAIをチェックする時代においても、最終的な判断と責任は人間が持つべきでしょう。

この新しい時代において、真に価値あるコンテンツとは何か、クリエイティビティとは何か、私たち一人ひとりが考え続けることが求められています。技術の進歩に翻弄されるのではなく、技術を活用しながらも人間らしさを失わない、そんなバランスを見つけることが、これからのコンテンツクリエイターに求められる資質なのかもしれません。