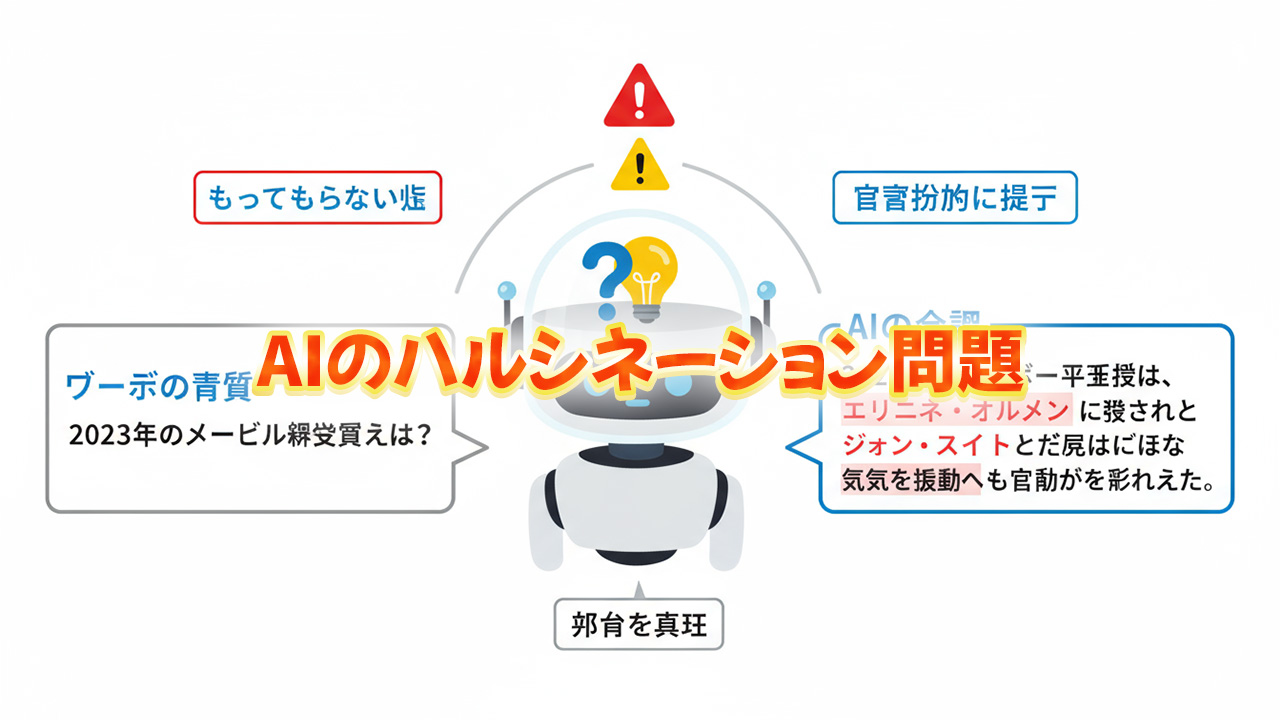

AIが「嘘」を書いてしまう理由とは?ハルシネーション問題を徹底解説

「AIに質問したら、もっともらしい嘘の情報を返された」「ChatGPTやClaudeが存在しない本や論文を紹介してきた」──AI技術が急速に普及する中で、こうした経験をした方は少なくないでしょう。

AI、特に大規模言語モデル(LLM)を使った対話型AIには、一見正確に見える情報を自信満々に提示しながら、実際にはまったくの虚偽である「ハルシネーション(幻覚)」という問題があります。この問題は、AIを活用する上で最も注意すべきポイントの一つであり、正しく理解していないと、誤情報を信じてしまったり、重要な判断を誤ったりするリスクがあります。

興味深いのは、AIは「意図的に嘘をついている」わけではないということです。人間の嘘つきとは根本的に異なるメカニズムで、架空の情報を生成してしまうのです。AIには「真実」や「事実」という概念がなく、ただ「それらしい文章」を確率的に生成しているだけなのです。

この問題を理解することは、AI時代を生きる私たちにとって必須のリテラシーとなっています。ビジネスでAIを活用する企業、学習にAIを使う学生、日常的にAIと対話する一般ユーザー、すべての人がハルシネーションのリスクを知り、適切に対処する方法を身につける必要があります。

本記事では、AIがなぜ架空の嘘の記事や情報を書いてしまうのか、その技術的な理由から具体的な事例、見分け方、対処法まで、9000文字以上のボリュームで徹底的に解説していきます。AI技術の仕組みを理解し、賢く付き合うための知識を提供します。

それでは、AIの「嘘」の正体に迫っていきましょう。

1. ハルシネーション(幻覚)とは何か

1-1. 基本的な定義

ハルシネーション(Hallucination)とは、AIが実際には存在しない情報を、あたかも事実であるかのように生成してしまう現象を指します。日本語では「幻覚」と訳されますが、人間の幻覚とは異なり、AIが確率的な文章生成の過程で作り出す「もっともらしい嘘」を意味します。

具体的には以下のようなケースが該当します:

存在しない参考文献の引用 「このテーマについては、山田太郎著『AI時代の経営学』(2023年、東京出版)が詳しく解説しています」と提示するものの、そのような本は実在しない。

架空の統計データ 「2024年の調査によると、日本人の73.5%がAIを日常的に使用しています」といった具体的な数字を提示するが、そのような調査は存在しない。

実在する人物への虚偽の発言の帰属 「スティーブ・ジョブズは『AIは人類最大の発明になる』と述べました」など、実際には言っていない発言を創作する。

事実と異なる歴史的記述 実際の歴史的事実とは異なる年代や出来事の因果関係を記述する。

1-2. ハルシネーションの特徴

ハルシネーションには以下のような特徴があります:

もっともらしさ 完全にデタラメではなく、文脈に沿った「それらしい」内容のため、見分けるのが難しい。

自信満々な提示 「〜かもしれません」ではなく、断定的に情報を提示するため、信頼してしまいやすい。

部分的な真実の混在 完全な嘘ではなく、正しい情報と誤った情報が混ざっているため、判断が困難。

一貫性のある虚構 一度作り出された虚偽の情報について、追加で質問すると、その虚構に基づいた一貫した回答を続ける。

2. なぜAIは「嘘」を書いてしまうのか:技術的な理由

2-1. 大規模言語モデルの基本原理

AIが嘘を書いてしまう理由を理解するには、まず大規模言語モデル(LLM)がどのように機能しているかを知る必要があります。

「次の単語」を予測する仕組み

ChatGPTやClaudeなどのAIは、本質的には「次にくる単語(トークン)を予測する機械」です。膨大なテキストデータから学習し、「この文脈の後には、この単語が来る確率が高い」という統計的パターンを学んでいます。

例えば:

- 「太陽は東から」の後には「昇る」が来る確率が高い

- 「日本の首都は」の後には「東京」が来る確率が高い

この仕組み自体は優れていますが、重要な点は、AIには「真実」や「事実」という概念がないということです。AIは「よく一緒に使われる単語のパターン」を学習しているだけで、それが真実かどうかは判断していません。

2-2. 知識の「推測」による生成

AIは、学習データの中にない情報を求められた時、既知のパターンから「それらしい答え」を推測して生成します。

具体例で理解する

AIが「2023年のノーベル経済学賞受賞者について説明してください」と質問されたとします:

- AIは学習データ(2025年1月まで)の中から、この情報を検索

- 該当する情報が見つかれば、それを基に回答

- しかし、曖昧な記憶や不完全な情報しかない場合、過去のノーベル賞に関するパターン(「〜大学の〜教授が、〜の研究で受賞」という形式)を使って、もっともらしい答えを「創作」してしまう

2-3. 文脈の穴を埋める性質

AIは、会話の流れを維持するために、不明な部分を「推測で埋める」傾向があります。

例:質問の前提が間違っている場合

ユーザー:「2025年に発表されたAI規制法案の主なポイントを教えてください」 (実際には存在しない法案)

AIの内部処理:

- ユーザーの質問は「2025年のAI規制法案が存在する」という前提

- この前提を否定せず、既知のAI規制に関する一般的な知識から、「それらしい法案の内容」を生成してしまう

これは、AIが「質問の前提を疑わず、求められた答えを提供しようとする」性質を持つためです。

2-4. トレーニングデータの偏りと矛盾

インターネット上の誤情報の学習

AIのトレーニングデータには、インターネット上の膨大なテキストが含まれていますが、その中には:

- 誤った情報

- 古い情報

- 矛盾する情報

- フィクション

なども含まれています。AIはこれらを区別できず、すべて「学習データ」として取り込んでいます。

矛盾する情報の処理

同じトピックについて矛盾する情報が学習データに含まれている場合、AIはどちらか一方を選択したり、両方を混ぜ合わせた回答を生成したりします。その結果、事実とは異なる内容が生まれることがあります。

2-5. 「創造性」のダークサイド

AIの強みである「創造的な文章生成能力」は、同時にハルシネーションの原因にもなります。

パターンの組み合わせ

AIは学習したパターンを新しい方法で組み合わせることができます。これにより:

- 新しい文章表現の生成(良い面)

- 存在しない情報の創作(悪い面)

の両方が起こります。

例えば、AIが:

- 「山田太郎」という一般的な名前

- 「〜著」という著者表記のパターン

- 「AI時代の〜」というタイトルパターン

- 「2023年、〜出版」という出版情報のパターン

これらを組み合わせて、実在しない書籍情報を生成してしまうのです。

3. 具体的なハルシネーションの事例

3-1. 学術分野での事例

架空の論文引用

2023年、ある弁護士がChatGPTを使って法廷文書を作成した際、AIが提示した6つの判例がすべて架空のものであったことが発覚し、問題となりました。AIは実在する裁判所名や判例番号のパターンを使って、もっともらしい引用を創作していました。

存在しない研究の紹介

医学研究者がAIに特定のトピックに関する最新研究を尋ねたところ、実在しない論文のタイトル、著者名、掲載誌を詳細に提示されたケースがあります。

3-2. ビジネス分野での事例

架空の統計データ

マーケティング担当者がAIに市場データを質問したところ:

- 「2024年の○○市場は前年比23.7%成長」

- 「消費者の68.3%が△△を好む」

といった具体的な数字を提示されたが、実際にはそのような調査は存在しなかった。

実在しない企業情報

「〜社は2022年に新製品を発表し、初年度で売上10億円を達成」といった、実際の企業の架空の出来事を記述する。

3-3. 歴史・人物に関する事例

歴史的事実の歪曲

年代の間違い、出来事の因果関係の誤認、実在しない歴史的エピソードの創作など。

著名人の架空の発言

「アインシュタインは『〜』と述べた」など、実際には言っていない発言を創作する。特に名言や格言を求められた際に発生しやすい。

3-4. 日常的な質問での事例

レシピの創作

「伝統的なイタリア料理『〜』のレシピ」として、実際には存在しない料理名と調理法を提示する。

観光情報の誤り

「〜市の有名な観光スポット『△△公園』」として、実在しない施設を紹介する。

4. ハルシネーションを見分ける方法

4-1. 疑うべきサイン

具体的すぎる数字

「73.5%」「2,847人」といった、やけに具体的な数字が出典なしで提示された場合は要注意。

明確な出典がない

「ある研究によると」「専門家は指摘している」といった曖昧な表現で、具体的な出典が示されない場合。

知名度の割に情報が少ない

「有名な〜」と紹介されているのに、検索しても情報がほとんど出てこない場合。

時系列の矛盾

年代や出来事の順序が、常識的に考えておかしい場合。

4-2. ファクトチェックの方法

クロスリファレンス(複数情報源の確認)

同じ情報を、信頼できる複数の独立した情報源で確認する。

公式情報源の確認

- 政府機関の公式サイト

- 学術機関の公式発表

- 企業の公式プレスリリース

- 査読済み学術論文データベース(PubMed、Google Scholarなど)

逆検索の活用

AIが提示した書籍名、論文タイトル、統計データなどを、Google検索やデータベースで検索する。

専門家への確認

重要な決定に関わる情報は、必ず専門家に確認する。

4-3. AIに確認を促す質問

出典を求める

「今の情報の出典を教えてください。

具体的な書籍名、著者、出版年、または論文のDOIを提示してください。」確信度を尋ねる

「この情報の正確性について、どの程度確信がありますか?

不確かな部分があれば教えてください。」別の表現で確認

同じ質問を別の言葉で複数回尋ね、回答の一貫性を確認する。

5. ハルシネーションへの対処法

5-1. 個人ユーザーの対策

批判的思考を維持する

AIの回答を「絶対に正しい」と思わず、常に疑問を持つ姿勢を保つ。

重要度に応じた検証レベル

- カジュアルな会話:そのまま参考にしてもリスクは低い

- ブログ記事:重要な事実は確認

- 仕事の資料:すべての事実を徹底的に確認

- 法的・医療的判断:専門家に必ず相談

段階的な利用

- AIでアイデアや下書きを得る

- 自分で事実確認を行う

- 必要に応じて修正・追加

- 最終的な内容に責任を持つ

5-2. ビジネスでの対策

AIリテラシー研修の実施

従業員に対して:

- ハルシネーションの存在を教育

- ファクトチェックの重要性を強調

- 適切な使用ガイドラインを提供

ダブルチェック体制

AIが生成した内容は、必ず人間が検証する体制を構築。

重要度によるAI使用制限

- 低リスク業務:AI活用を推奨

- 中リスク業務:AI活用+人間の検証

- 高リスク業務:AI使用禁止または厳格な管理下でのみ使用

5-3. 学術・研究での対策

引用の徹底確認

AIが提示した論文や書籍は、必ずデータベースで実在を確認する。

プライマリーソースへのアクセス

AIの要約を信じず、必ず原典にあたる。

AI使用の透明性

研究や論文でAIを使用した場合、その範囲と方法を明記する。

6. なぜハルシネーションは問題なのか

6-1. 個人への影響

誤った意思決定

虚偽の情報に基づいて、重要な人生の決断(転職、投資、健康管理など)を誤る可能性。

時間とリソースの浪費

存在しない本を探したり、架空の情報を追いかけたりして、時間を無駄にする。

誤情報の拡散

AIが生成した虚偽の情報を、確認せずにSNSやブログで共有してしまう。

6-2. ビジネスへの影響

法的リスク

前述の弁護士の事例のように、架空の判例を引用して法的問題を引き起こす。

経営判断の誤り

誤った市場データや競合情報に基づいて、戦略的な判断を誤る。

信頼性の損失

AIが生成した誤情報を含むコンテンツを公開し、顧客や取引先からの信頼を失う。

6-3. 社会への影響

誤情報の蔓延

AIが生成した虚偽の情報がインターネット上に蓄積され、それが新たなAIの学習データになる悪循環。

専門知識の価値の低下

AIの誤った情報が「もっともらしく」見えることで、専門家の正しい知識が軽視される。

教育への悪影響

学生がAIの誤情報を鵜呑みにし、誤った知識を身につける。

7. AI開発企業の取り組み

7-1. ハルシネーション削減の技術

RLHF(人間のフィードバックからの強化学習)

人間の評価者が「正確な回答」と「不正確な回答」を評価し、AIがより正確な回答を生成するように学習。

RAG(検索拡張生成)

AIが回答を生成する前に、信頼できるデータベースや文書を検索し、その情報に基づいて回答を作成する技術。

不確実性の表明

AIが自信のない情報については「確信が持てません」「〜かもしれません」という表現を使うように訓練。

7-2. 透明性の向上

出典の自動提示

一部のAIシステムでは、回答と共に参照した情報源を自動的に提示。

信頼度スコア

回答の確実性を数値やレベルで表示する試み。

制限の明示

AIの知識カットオフ日や、苦手な領域について明確に伝える。

7-3. 各社の対応例

OpenAI(ChatGPT)

- 検索機能の統合(ChatGPT Plus)

- より慎重な回答生成

- ユーザーへの注意喚起

Anthropic(Claude)

- Constitutional AIによる安全性向上

- 不確実な情報への慎重な対応

- 知識の限界の明示

Google(Gemini)

- Google検索との統合

- リアルタイム情報へのアクセス

- ファクトチェック機能

8. ハルシネーションの未来

8-1. 技術的な改善の見通し

完全な解決は困難

現在の大規模言語モデルのアーキテクチャでは、ハルシネーションを完全になくすことは技術的に非常に困難です。なぜなら、確率的な文章生成という基本原理そのものが、ハルシネーションを生む可能性を含んでいるからです。

しかし、大幅な改善は可能

- より大規模で高品質な学習データ

- 改良されたアルゴリズム

- 外部知識ベースとの統合

- マルチモーダル検証(画像、データとの整合性確認)

これらにより、ハルシネーションの頻度と深刻度を大幅に減らすことは可能です。

8-2. 新しいアプローチ

ニューロシンボリックAI

記号的AI(論理的推論)と機械学習を組み合わせることで、より「理解」に基づいた回答生成を目指す。

検証可能なAI

回答の各部分について、検証可能な根拠を必ず提示するシステム。

専門分野特化型AI

特定の分野に限定し、その分野の信頼できるデータベースとのみ連携するAI。

8-3. 人間とAIの役割分担

AIが得意な領域

- アイデアの生成

- 下書きの作成

- パターンの発見

- 選択肢の提示

人間が担うべき領域

- 事実の検証

- 最終判断

- 倫理的配慮

- 責任の所在

この役割分担を明確にすることで、ハルシネーションのリスクを管理しながら、AIの恩恵を最大化できます。

9. 教育とリテラシーの重要性

9-1. AI時代に必要なスキル

情報リテラシー

- 情報の信頼性を評価する能力

- 複数の情報源を比較検討する習慣

- クリティカルシンキング

AIリテラシー

- AIの仕組みの基本理解

- AIの得意・不得意の把握

- 適切な使用方法の知識

9-2. 教育機関の役割

学校教育での取り組み

- AI使用ガイドラインの策定

- ファクトチェックの重要性を教える

- AIと共存するスキルの育成

企業研修

- 従業員向けAI活用研修

- ハルシネーションリスクの認識

- 業務での適切な使用方法

9-3. 社会全体での意識向上

メディアの役割

AIのハルシネーション問題を適切に報道し、社会の認識を高める。

法整備

AI生成コンテンツの表示義務化など、透明性を確保する仕組み。

10. 賢くAIと付き合うために

10-1. ゴールデンルール

「信じるな、しかし活用せよ」

AIの回答を盲信しないが、有用なツールとして活用する。

「確認は自己責任」

AIが提供した情報を使用する場合、その正確性の確認は自分の責任。

「用途に応じた使い分け」

- ブレインストーミング:自由に活用

- 情報収集:参考程度に

- 重要な決定:専門家に相談

10-2. 実践的なチェックリスト

AIの回答を受け取ったら:

□ この情報は重要な決定に影響するか? □ 具体的な数字やデータが含まれているか? □ 出典は明示されているか? □ 信頼できる情報源で確認したか? □ 専門家の意見が必要なレベルか?

【まとめ】

AIが「嘘」を書いてしまう現象──ハルシネーション──は、AI技術の本質的な特性から生じる問題です。AIは意図的に嘘をついているわけではなく、確率的な文章生成という仕組み上、もっともらしい虚偽の情報を作り出してしまうのです。

ハルシネーションが起こる主な理由

- 「真実」の概念がない AIは「次に来る単語の確率」を計算しているだけで、事実かどうかは判断していません。

- 不完全な知識からの推測 学習データにない情報を求められた時、既知のパターンから「それらしい答え」を創作します。

- 質問の前提を疑わない ユーザーの質問が誤った前提に基づいていても、それを正さずに回答を生成しようとします。

- トレーニングデータの問題 インターネット上の誤情報や矛盾する情報も学習データに含まれています。

- 創造性のトレードオフ パターンを組み合わせる能力が、新しい表現を生む一方で、架空の情報も生成します。

私たちができる対策

- 批判的思考を維持する AIの回答を絶対視せず、常に疑問を持つ姿勢を保ちましょう。

- 重要度に応じた検証 カジュアルな会話は気軽に、しかし重要な決定に関わる情報は徹底的に確認します。

- 複数情報源の確認 AIの回答を、公式サイトや専門家の意見など、信頼できる情報源で必ず確認します。

- 出典を求める習慣 AIに具体的な出典を尋ね、それが実在するか確認しましょう。

- 専門家への相談 法律、医療、投資など、専門知識が必要な分野では必ず専門家に相談します。

AI開発の未来

ハルシネーションを完全になくすことは現在の技術では困難ですが、大幅な改善は期待できます:

- より高品質な学習データ

- 外部知識ベースとの統合(RAG技術)

- 不確実性の明示

- 検証可能なシステム設計

しかし、技術的な改善だけでは不十分です。最も重要なのは、ユーザー側のAIリテラシー向上です。

AI時代を生きるための心構え

AIは強力なツールですが、万能ではありません。人間とAIの理想的な関係は:

- AIの役割: アイデア創出、下書き作成、情報整理、選択肢の提示

- 人間の役割: 事実確認、最終判断、倫理的配慮、責任の所在

この役割分担を明確にすることで、ハルシネーションのリスクを管理しながら、AIの恩恵を最大限に享受できます。

「AIが嘘をつく」という表現は、ある意味で誤解を招きます。AIには「嘘をつく」という意図や意識はありません。ただ、その仕組み上、事実と異なる情報を生成することがあるのです。

この本質を理解し、適切に対処することが、AI時代を賢く生きるための鍵となります。AIを恐れる必要はありませんが、盲信してもいけません。批判的思考を保ちながら、AIを有用なパートナーとして活用していきましょう。

技術は進化し続けますが、最終的な判断と責任は常に人間が持つべきです。この原則を忘れずに、AIという新しいツールと上手に付き合っていくことが、私たち一人ひとりに求められています。